در قسمتهای اول تا چهارم، به ترتیب درباره کلیات هوش مصنوعی، یادگیری ماشین، یادگیری عمیق و هوش مصنوعی مولد صحبت کردیم. اکنون به نقطهای رسیدهایم که تقریباً مکانیسمهای اصلی LLMهای پیشرفته فعلی را درک میکنیم. بنابراین در این قسمت پایانی، به سراغ آموزش برخی ترفندهای استفاده از LLM ها میرویم که میتواند بهرهوری آنها را افزایش دهد.

ممکن است فکر کنید ماجرای مدل های زبانی بزرگ، آنقدرها هم جادویی نیست، زیرا تمام آنچه اتفاق میافتد پیشبینی یک به یک کلمات است، یعنی آمار محض. حق با شماست! کاری که این مدلها انجام میدهند، جادویی نیست، بلکه اینکه آنها این کار را بسیار خوب انجام میدهند، عجیب است! در واقع، همه، حتی محققان OpenAI، از اینکه این نوع مدلسازی زبان تا کجا میتواند پیش برود، متعجب شده بودند. یکی از محرکهای کلیدی در چند سال اخیر، مقیاسپذیری گسترده شبکههای عصبی و مجموعههای داده بوده که باعث افزایش عملکرد آنها شده است. به عنوان مثال، GPT-4، مدلی با بیش از یک تریلیون پارامتر، میتواند در آزمون وکالت یا زیستشناسی AP با امتیازی در بازهی امتیاز ۱۰ درصد برتر شرکت کنندگان قبول شود.

با کمال تعجب، LLM های بزرگ حتی تواناییهای نوظهور خاصی را نشان میدهند، به عنوان مثال، توانایی انجام کارهایی که مستقیماً برای انجام آنها آموزش ندیدهاند. در بخش پایانی مقاله، برخی از این تواناییهای نوظهور را مورد بحث قرار داده و ترفندهای استفاده از LLM را به شما نشان میدهیم که میتوانید از آنها برای حل مسائل استفاده کنید.

یک قابلیت جالب این است که LLM ها میتوانند کارهای کاملا جدیدی انجام دهند که در آموزش با آنها مواجه نشدهاند. این قابلیت، پرامپت صفر شاتی (zero-shot) نام دارد. تنها چیزی که لازم است به آنها بگویید چند دستورالعمل در مورد چگونگی انجام کار است. مثلاً میتوانیم از یک LLM بخواهیم که یک جمله را از آلمانی به انگلیسی ترجمه کند، به طوری که این ترجمه فقط شامل کلماتی باشد که با “f” شروع میشوند. بنابراین وقتی جمله “Die Katze schläft gerne in der Box” (که آلمانی است و به معنای “گربه دوست دارد در جعبه بخوابد”) به LLM داده شد، پاسخش این بود:

“Feline friend finds fluffy fortress” که ترجمه بسیار جالبی است.

احتمالا به سرعت متوجه میشوید که برای کارهای پیچیدهتر، پرامپت صفر شات به دستورالعملهای بسیار دقیقی نیاز دارد و حتی در آن صورت هم، پاسخ کامل و بینقصی نخواهیم گرفت. اگر بخواهیم ارتباط این موضوع را با هوش انسان نشان دهیم، میتوانیم بگوییم اگر کسی به شما بگوید که کار جدیدی را انجام دهید، احتمالاً نمونههایی از نحوه انجام آن کار را از او درخواست خواهید کرد. این امر در مورد LLMها هم صدق میکند و آنها نیز میتوانند از این مزیت بهرهمند شوند.

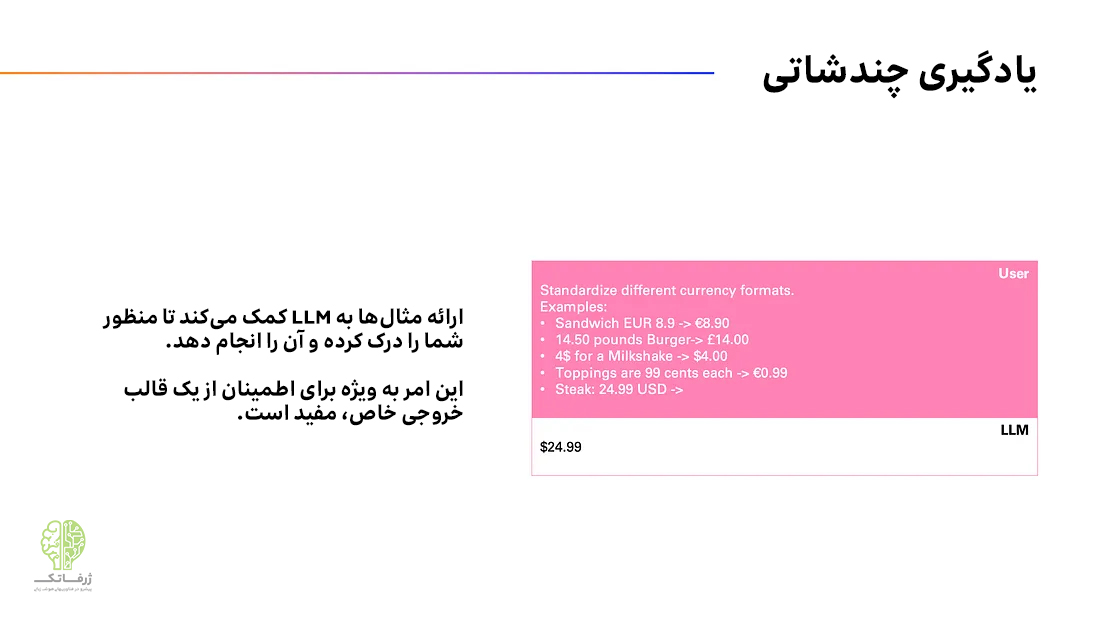

به عنوان مثال، فرض کنید مدلی را میخواهید که مقادیر مختلف ارز را به یک فرمت مشترک تبدیل کند. میتوانید آنچه را که میخواهید با جزئیات توصیف کنید یا فقط یک دستورالعمل مختصر و چند نمونه به آن ارائه دهید. تصویر بالا نمونهی این کار را نشان میدهد. با استفاده از این دستور، مدل باید در آخرین مثال، که «استیک: ۲۴.۹۹ دلار» است، به خوبی عمل کند و به صورت ۲۴.۹۹ $ پاسخ دهد. توجه داشته باشید که چگونه به سادگی راه حل را برای مثال آخر حذف کردیم. به یاد داشته باشید که یک LLM در واقع یک کامل کننده متن است، بنابراین سعی کنید ساختار ثابتی را در سوالات خود رعایت کنید. مانند مثال بالا، باید مدل را مجبور کنید دقیقاً همان چیزی را که میخواهید پاسخ دهد.

به طور خلاصه، در صورتی که LLM با روش صفر شات مشکل دارد، چند مثال به آن ارائه دهید. متوجه خواهید شد که این کار به LLM کمک میکند تا سؤال شما را درک کند و عملکرد بهتر و قابل اطمینانتری ارائه کند.

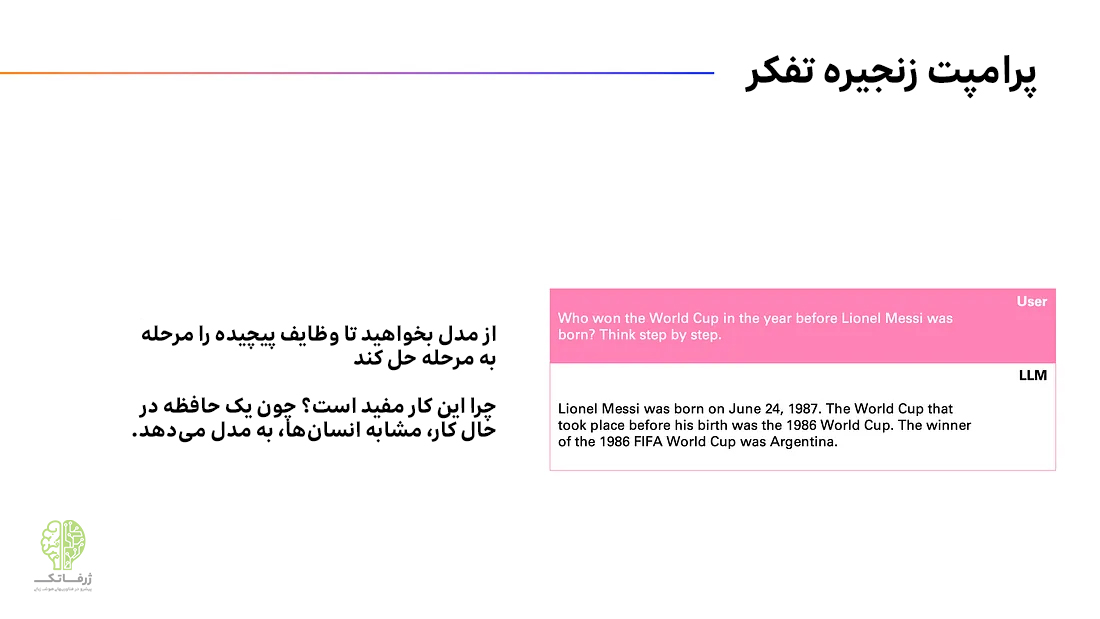

یکی دیگر از ترفندهای استفاده از LLM که یادآور هوش انسان است، زنجیره تفکر است؛ به ویژه اگر کار پیچیدهتر بوده و حل آن نیاز به چندمرحله استدلال داشته باشد. فرض کنید از شما بپرسیم «چه کسی در سال قبل از تولد لیونل مسی جام جهانی را برد؟» چگونه پاسخ میدهید؟ احتمالاً به صورت مرحله به مرحله و با درنظر گرفتن مراحل میانی، پاسخ صحیح را مییابید. این دقیقاً همان کاری است که LLM ها نیز میتوانند انجام دهند.

مشخص شده که صرفاً خواستن از LLM که به صورت «گام به گام فکر کند» میتواند عملکرد آن را در بسیاری از وظایف به طور قابل توجهی افزایش دهد. چرا؟ زیرا این نوع دانشِ ترکیبیِ غیرمعمول، احتمالاً مستقیماً در حافظه داخلی LLM وجود ندارد؛ با این حال، حقایق تکتک، مانند تولد مسی و برندگان جامهای جهانی مختلف در آن وجود دارند.

این نحوه درخواست برای تفکر گام به گام برای رسیدن به پاسخ نهایی، به LLM کمک زیادی میکند، زیرا به آن زمان میدهد تا با صدای بلند فکر کند و مسائل فرعی سادهتر را قبل از دادن پاسخ نهایی حل کند. به یاد داشته باشید که هر کلمهی قبلی در یک دنباله، زمینهای مفهومی است که مدل میتواند به آن تکیه کند. بنابراین، همانطور که در تصویر بالا نشان داده شده است، زمانی که مدل پاسخ میدهد «آرژانتین»، تولد مسی و سال جام جهانی که ما در مورد آن سؤال کردیم، قبلاً در حافظه کاری LLM بودهاند که این امر، دادن پاسخ صحیح را آسان تر میکند.

ترفندهای استفاده از LLM

اکنون به سؤالی که در قسمتهای قبلی پرسیدیم پاسخ میدهیم. آیا LLM فقط کلمه بعدی را پیشبینی میکند یا ماجرا فراتر از این حرفهاست؟ برخی محققان مورد دوم را درست میدانند و استدلال میکنند برای اینکه LLM در هر زمینهای در پیشبینی کلمه بعدی بسیار خوب عمل کند، باید درک فشردهای از جهان را در درون خود به دست آورده باشد. اما دیگران استدلال میکنند که چنین چیزی درست نیست، زیرا مدل فقط یاد گرفته الگوهای مشاهده شده در طول آموزش را بدون درک واقعی از زبان، جهان یا هر چیز دیگری به خاطر بسپارد و کپی کند.

احتمالاً در این مرحله، به طور واضح پاسخ درست یا غلطی وجود ندارد؛ بلکه فقط نگاههای متفاوت از زوایای مختلف به یک چیز یکسان وجود دارد. واضح است که این LLM ها بسیار مفید هستند و دانش و تواناییهای استدلالی چشمگیری نشان میدهند و حتی ممکن است جرقههایی از هوش عمومی را نشان دهند. اما اینکه این هوش تا چه حد به هوش انسان شباهت دارد، هنوز مشخص نیست.

امیدواریم این سری مقالات به شما کمک کرده باشد تا LLM ها و جنون جاری پیرامون آنها را درک کنید تا بتوانید در مورد پتانسیل ها و خطرات هوش مصنوعی به دیدگاه جامعی برسید. تصمیمگیری درباره نحوه استفاده از هوش مصنوعی به نفع جهان، تنها به محققان هوش مصنوعی و دانشمندان داده بستگی ندارد؛ بلکه همه باید بتوانند حرفی برای گفتن داشته باشند. به همین دلیل مطالعه چنین مقالاتی که به دانش و پیشزمینه زیادی نیاز نداشته باشند، لازم است.

در پایان سری مقالات آموزش مدل های زبانی بزرگ، میخواهیم به چند سؤال مهم پاسخ دهیم:

- آیا LLM نوعی هوش است؟ احتمالاً.

- آیا این هوش شبیه انسان است؟احتمالاً نه.

- آیا AI احساسات دارد؟ نه (در گفتگو با چتباتها، «لطفا» و «متشکرم» لازم نیست!)

- آیا AI دارای سوگیری است؟ بله متأسفانه بسیاری از آنها سوگیری را از دادههای آموزشی به ارث میبرند.

- آیا باید از پیشرفت AI بترسیم یا هیجان زده شویم؟ تصمیم با شماست، AI هم فرصتهایی دارد و هم خطراتی!

- و در نهایت، آیا AI جادویی است؟ به هیچ وجه!